这篇文章介绍如何在Windows上运行Apache Spark 。

一、环境要求

运行spark需要以下条件的支持:

- Java6+

- Scala 2.10.x

- Hadoop 2.7.x

二、安装步骤

- 安装Jdk 7 或更高版本,设置Java_Home和Path环境变量;

- 下载scala 2.10或更高版本,安装后设置Scala_Home并把%Scala_Home%\bin添加到path的后面;

- 安装hadoop,并设置

hadoop_home,把%hadoop_home%\bin添加到path的后面(安装过程参考[这里]); - 安装spark;

三、安装spark

安装spark是本文记录的重点,spark的安装有两种方式,分别是:

- 通过SBT构建spark;

- 使用spark预构建安装包;

本文介绍的是通过spark预构建安装包进行spark环境的搭建,spark预构建安装包的下载地址>>Go to Download。

- 解压安装包spark-1.6.1-bin-hadoop2.6.tgz;

- 设置spark_home并把%spark_home%\bin添加到path环境变量中;

- 运行cmd命令,在命令行窗口运行“spark-shell”;

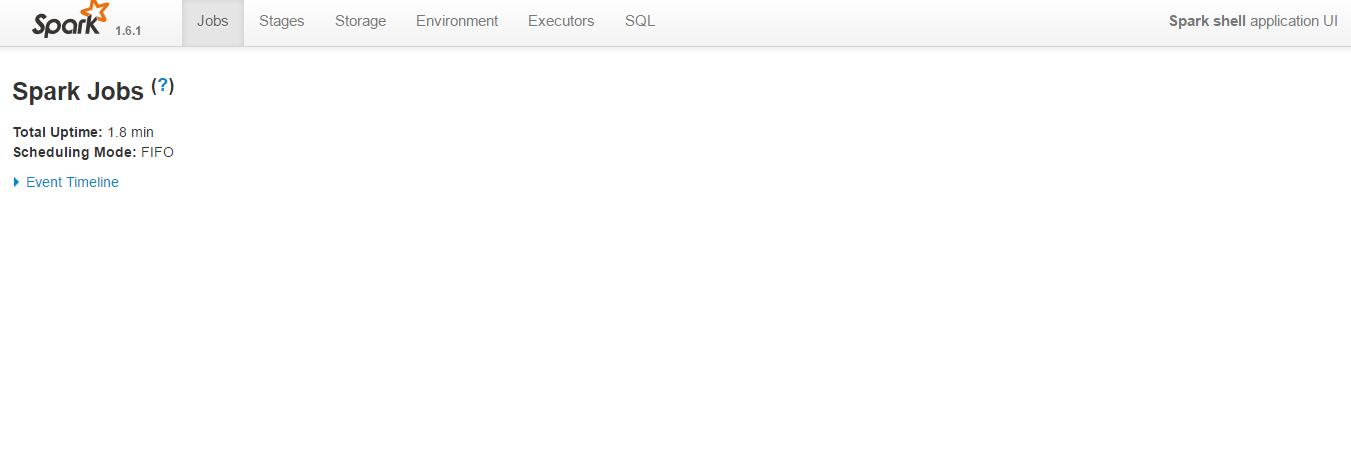

- 在浏览器窗口输入:http://localhost:4040/;

如果在浏览器中看到spark shell ui则说明安装成功。

四、启动Master

在D:\Programs\spark-1.6.1-bin-hadoop2.6\conf目录下,新建spark-env.cmd文件,内容大致如下:

set SCALA_HOME=C:\scala

set SPARK_CLASSPATH=C:\spark\bin\..\conf;C:\spark\bin\..\lib\spark-assembly-1.1.0-hadoop2.3.0.jar;C:\spark

\bin\..\lib\datanucleus-api-jdo-3.2.1.jar;C:\spark\bin\..\lib\datanucleus-core-3.2.2.jar;C:\spark\bin\..\lib\

datanucleus-rdbms-3.2.1.jar;C:\scala\lib\scala-library.jar;C:\scala\lib\scala-compiler.jar;

然后进入D:\Programs\spark-1.6.1-bin-hadoop2.6\bin目录,执行:

spark-class.cmd org.apache.spark.deploy.master.Master

参考文章:

- http://nishutayaltech.blogspot.sg/2015/04/how-to-run-apache-spark-on-windows7-in.html;

- http://prasi82.blogspot.sg/2015/11/setup-spark-on-windows.html;

- http://apache-spark-user-list.1001560.n3.nabble.com/How-to-start-master-and-workers-on-Windows-td12669.html;

最新评论

有没有港台节目直播?

One Drive提取密码?

大佬请问每次都需要在plugins中启动tiktok吗,还是直接启动app

不是个人的吧,华为应用商店里有公司名称,可以搜到的